I fact-checker del Regno Unito stanno inviando la loro intelligenza artificiale per aiutare gli americani a coprire le elezioni

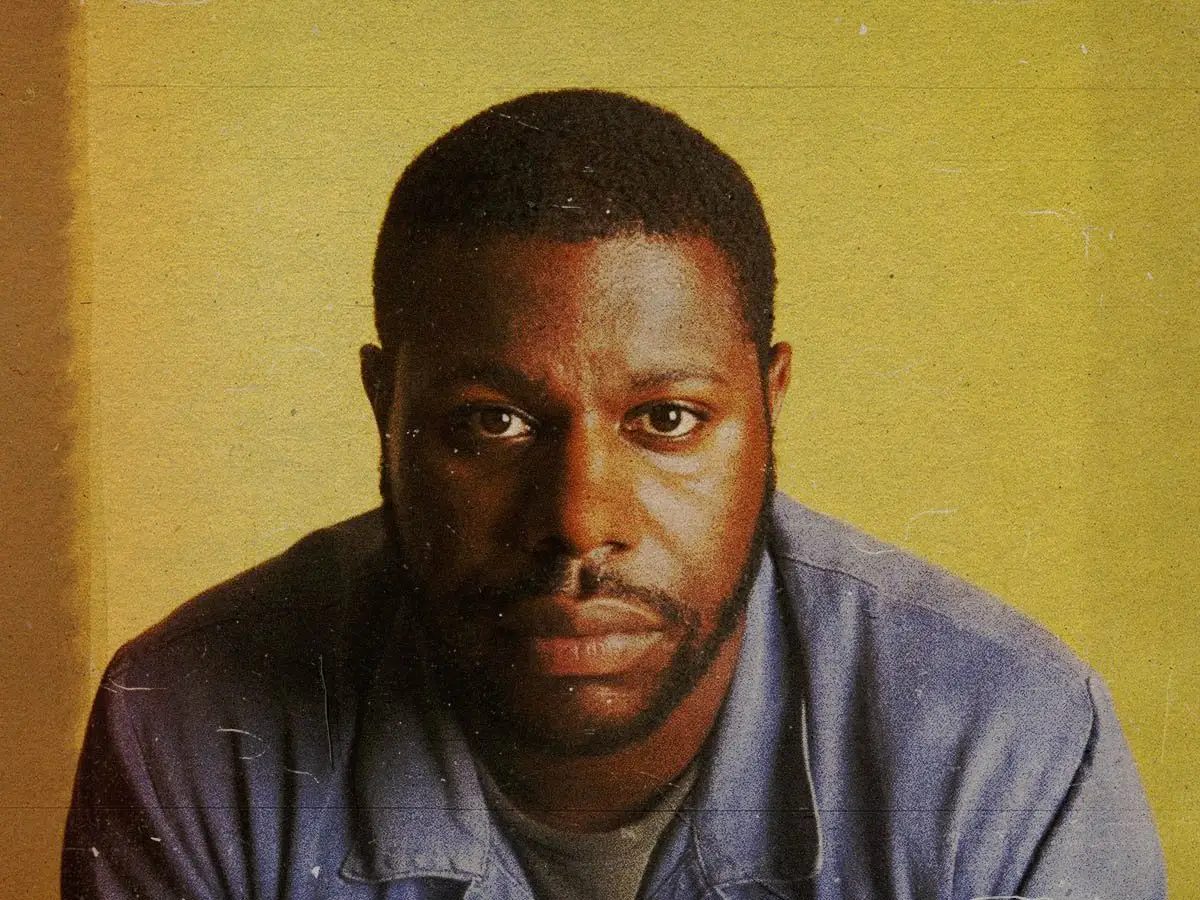

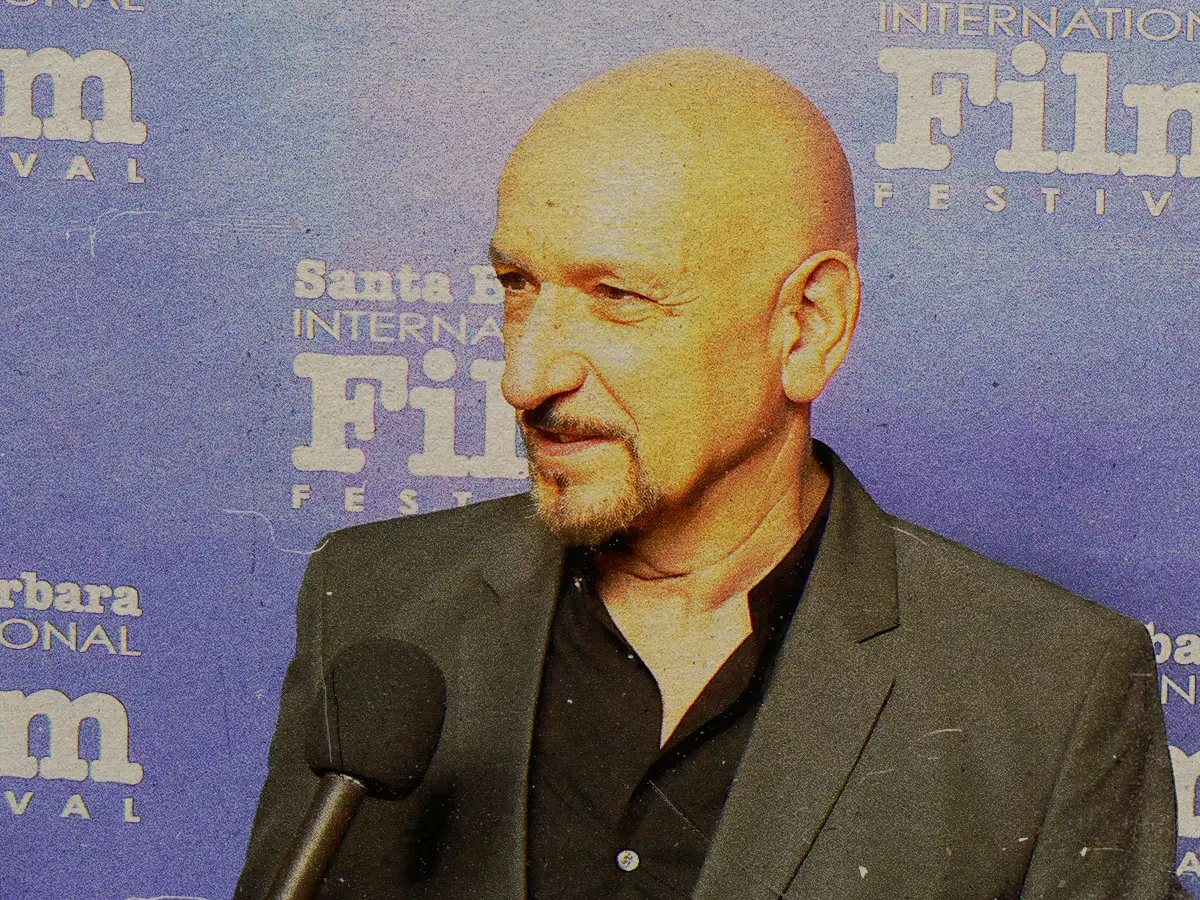

Da sinistra: il responsabile dell'intelligenza artificiale di Full Fact, Andy Dudfield, Kate Wilkinson, senior product manager, e il data scientist senior David Corney. (Per gentile concessione di Full Fact)

Da sinistra: il responsabile dell'intelligenza artificiale di Full Fact, Andy Dudfield, Kate Wilkinson, senior product manager, e il data scientist senior David Corney. (Per gentile concessione di Full Fact)All’interno di un modesto ufficio vicino al London Bridge, un piccolo team di ingegneri e verificatori di fatti ha trascorso un decennio a perfezionare strumenti e modelli di intelligenza artificiale per fare ciò che la maggior parte dei giornalisti non è più in grado di gestire: tenere il passo. Il sistema legge i titoli, trascrive le trasmissioni e scansiona i social media alla ricerca di affermazioni che meritano di essere verificate. Segnala coloro che hanno maggiori probabilità di fuorviare o causare danni.

La tecnologia sviluppata da Full Fact, la principale organizzazione benefica di fact-checking del Regno Unito, sta attraversando l’Atlantico. In vista delle elezioni di medio termine americane del 2026, che molti esperti di disinformazione si aspettano siano definite da falsità create dall’intelligenza artificiale, Full Fact invita le redazioni americane a testare i propri strumenti mentre cerca finanziamenti per espandere il proprio lavoro negli Stati Uniti.

Fondata nel 2009, Full Fact ha iniziato a sperimentare la tecnologia molto prima che i grandi modelli linguistici catturassero l'attenzione globale. Nel 2016 i suoi leader si erano resi conto che i fact-checkers umani non potevano più monitorare ogni trasmissione o piattaforma per individuare affermazioni discutibili su questioni di interesse pubblico. Quando Andy Dudfield è entrato nell'organizzazione nel 2019 per guidarne il lavoro sull'intelligenza artificiale, ha trovato un piccolo team già esplorando come l'automazione potrebbe aiutare.

La tecnologia di Full Fact è nata dall’elaborazione del linguaggio naturale prima dei modelli generativi di oggi. Il team ha iniziato con la formazione di sistemi per identificare le dichiarazioni verificabili e abbinarle ai fact check esistenti. Nel 2019 gli ingegneri hanno messo a punto il BERT di Google, un modello creato per comprendere il linguaggio anziché generarlo, per etichettare i tipi di affermazioni nelle notizie e nei social media.

Con decine di migliaia di annotazioni umane, il modello ha imparato a gestire vasti flussi di testo, elaborando più di 300.000 frasi al giorno e segnalando nuove affermazioni che riapparivano con formulazioni diverse. Negli ultimi due anni modelli generativi più ampi si sono uniti al mix stimando i danni potenziali e individuando versioni parafrasate che i vecchi sistemi non avrebbero potuto cogliere. I nuovi sistemi emergono e raggruppano la probabile disinformazione dannosa e i verificatori dei fatti decidono cosa indagare e pubblicare.

Gli utenti accedono agli strumenti attraverso una dashboard web che mostra le affermazioni provenienti dalle notizie, dai social media, dai podcast, dai video e dalla radio. L'interfaccia si collega a clip o post originali e consente ai team di effettuare ricerche per argomento o relatore per vedere dove sono apparse le affermazioni e ricevere avvisi quando riaffiorano dichiarazioni smentite. Se abilitato, il sistema può dare la priorità alle affermazioni potenzialmente dannose in modo che gli editori possano decidere su cosa lavorare per primo.

Tutto ciò che abbiamo costruito nella tecnologia è dal punto di vista di essere costruito da fact-checker per fact-checker, mi ha detto Dudfield. Non stavamo cercando di capire cosa la tecnologia avrebbe potuto fare per essere interessante. Stavamo cercando di trovare i problemi reali che abbiamo avuto con il controllo dei fatti e vedere se la tecnologia poteva aiutarci.

Questa distinzione ha dato forma a Full Fact AI, ora un team di otto persone al centro del lavoro dell’organizzazione di beneficenza. Il sistema analizza il potenziale danno di una richiesta valutando quanto sia sbagliata, quanto credibile sembri e quanto sia probabile che spinga le persone ad agire di conseguenza.

Il modello del danno si basa sulla ricerca di Peter Cunliffe-Jones, fondatore di Africa Check e autore di Fake News: What’s the Harm? In quel libro pubblicato dalla University of Westminster Press, Cunliffe-Jones traccia come le falsità possano innescare conseguenze misurabili: dagli attacchi di massa contro gli operatori sanitari durante l’epidemia di Ebola del 2014 ai linciaggi in India alimentati dalle bufale di WhatsApp sui rapitori di bambini. Tra il 2021 e il 2025 ha sviluppato un modello per prevedere quali false affermazioni avrebbero maggiori probabilità di causare danni reali.

I fact-checker devono concentrarsi su ciò che è più probabile che faccia un danno reale e non solo su ciò che è sbagliato, mi ha detto Cunliffe-Jones in un'e-mail. Il quadro di valutazione del danno di Full Fact applica quel modello su larga scala aiutando i fact-checker a indirizzare risorse limitate dove contano di più.

Gli strumenti sono stati utilizzati da più di 40 organizzazioni di verifica dei fatti in oltre 30 paesi, anche durante le elezioni presidenziali del 2023 in Nigeria, dove i fact-checker li hanno impiegati per tracciare e sfatare le affermazioni virali in tempo reale . Il sistema è una co-intelligenza tra uomo e macchina, ha affermato il senior product manager di Kate Wilkinson Full Fact che sta guidando la divulgazione alle redazioni statunitensi.

I nostri strumenti non sono progettati per sostituire i fact-checker, ha affermato Wilkinson. Tolgono dal piatto il compito davvero dispendioso in termini di tempo e risorse del monitoraggio dei media.

Full Fact ha iniziato a invitare i banchi di fact-checking statunitensi, dai team locali alle reti nazionali, per testare i suoi strumenti di intelligenza artificiale prima delle elezioni del prossimo anno. Wilkinson ha definito i tempi appropriati e ha affermato che la piattaforma potrebbe aiutare le redazioni a gestire le richieste elettorali su larga scala senza aggiungere personale tecnico. L'implementazione include licenze sovvenzionate e brevi sessioni di onboarding per aiutare i team a integrare rapidamente gli strumenti nel loro lavoro quotidiano.

La mossa arriva in un momento in cui molte redazioni no-profit e indipendenti si trovano ad affrontare crescenti difficoltà finanziarie mentre sperimentano come l’intelligenza artificiale può aiutarle a servire meglio il loro pubblico. Negli Stati Uniti Meta finito il suo programma di fact-checking di terze parti a gennaio ha costretto diversi punti vendita a ridimensionarsi e ha spinto quasi un terzo delle organizzazioni accreditate dall'International Fact-Checking Network a chiudere.

Due settimane fa Full Fact ha rivelato che Google aveva ritirato il suo sostegno di lunga data al lavoro sull’intelligenza artificiale dell’ente di beneficenza. L'organizzazione ha affermato di aver ricevuto più di 1 milione di sterline da Google lo scorso anno, direttamente o tramite fondi correlati, che ora sono stati interrotti.

Dudfield ha definito la perdita significativa ma non insormontabile. La tecnologia non è qualcosa che facciamo a Full Fact, ha detto. È il fulcro di ciò che facciamo.

In una dichiarazione, l’amministratore delegato di Chris Morris Full Fact ha affermato che l’organizzazione di beneficenza sta riorientando urgentemente la propria raccolta fondi pur rimanendo indipendente. Morris, il primo fact-checker in diretta della BBC, ha anche criticato quello che ha descritto come un brivido politico da parte della Silicon Valley. Riteniamo che le decisioni di Google e quelle di altre grandi aziende tecnologiche statunitensi siano influenzate dalla necessità percepita di compiacere l’attuale amministrazione statunitense. ha scritto . I fatti saranno sempre chiari: i fatti verificabili contano e le grandi aziende di Internet hanno delle responsabilità quando si tratta di limitare la diffusione di disinformazione dannosa.

I tagli ai finanziamenti seguono a ritiro più ampio da parte delle principali aziende tecnologiche dal sostenere il fact-checking a livello globale. Dudfield ha affermato che il contesto in evoluzione ha rafforzato la missione del suo team di utilizzare la tecnologia per sostenere la verifica indipendente. Continueremo a utilizzare la tecnologia per supportare il fact-checking perché crediamo che sia lì che possiamo fare la differenza più grande, ha affermato.

L’espansione di Full Fact arriva in un momento cruciale per il fact-checking, ha affermato Lucas Graves, professore di giornalismo presso l’Università del Wisconsin-Madison e autore di Deciding What’s True: The Rise of Political Fact-Checking in American Journalism.

Ci sono moltissime sperimentazioni con l’intelligenza artificiale nel panorama dei media negli Stati Uniti, nelle redazioni grandi e piccole, ha detto. Ma ciò che Full Fact ha è una piattaforma appositamente sviluppata nell’arco di quasi un decennio per monitorare e dare priorità alla disinformazione, un’area in cui la maggior parte delle redazioni non ha un’enorme esperienza.

Graves ha definito l'espansione tempestiva, aggiungendo che la minaccia rappresentata dalla disinformazione online si sta evolvendo rapidamente mentre le risorse delle redazioni continuano a ridursi.

Nonostante i cambiamenti politici e il calo del sostegno all’industria, Dudfield ha affermato che l’obiettivo non è cambiato. Siamo verificatori di fatti. Controlliamo i fatti, ha detto. Il lavoro di smascherare le falsità, ha aggiunto, rimane essenziale anche se crescono le pressioni sui giornalisti indipendenti. L’alternativa, secondo lui, costerebbe molto di più.