Il rapporto sulla salute di RFK Jr. mostra come l’intelligenza artificiale inserisce studi falsi nella ricerca

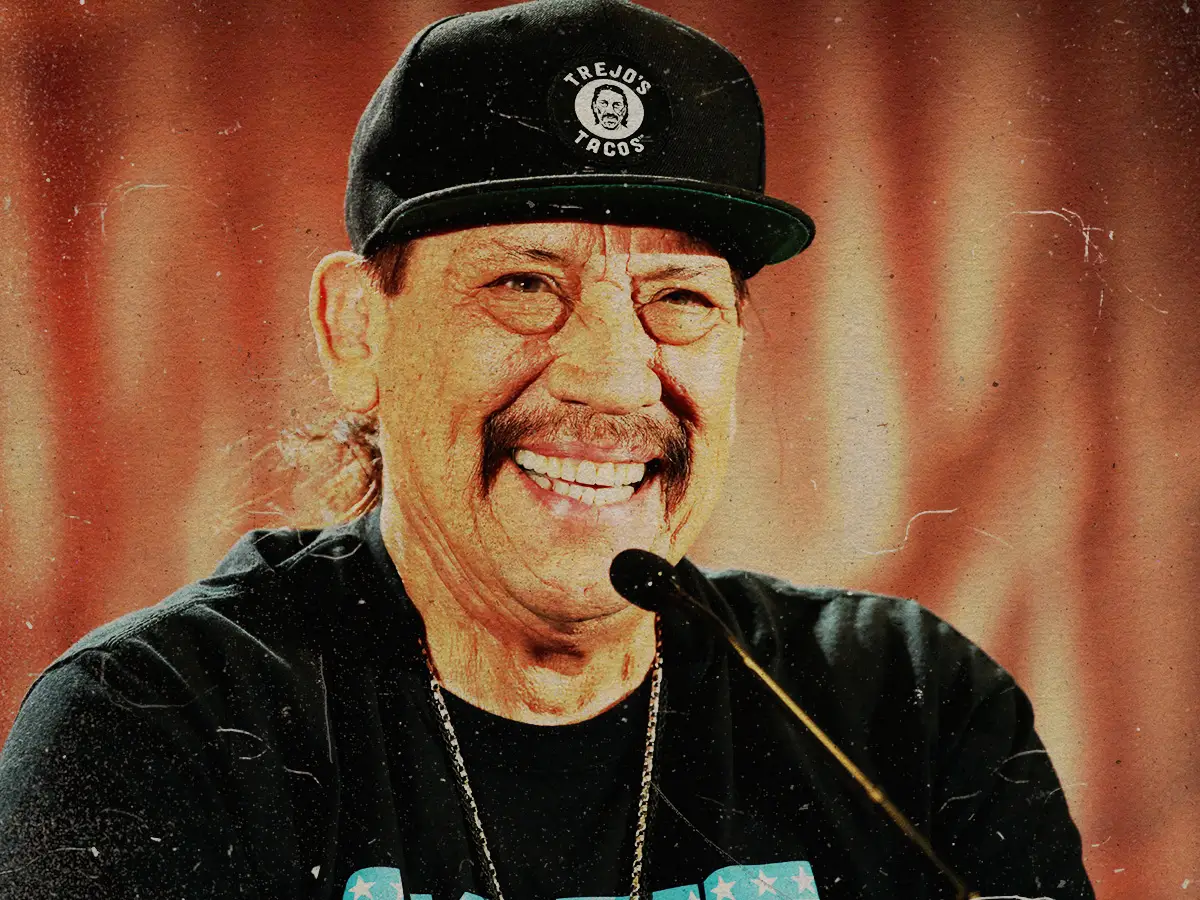

Il Segretario per la salute e i servizi umani Robert F. Kennedy Jr. parla mentre il Segretario per l'istruzione Linda McMahon ascolta durante un evento della Commissione Make America Healthy Again nella Sala Est della Casa Bianca giovedì 22 maggio 2025 a Washington. (AP Photo/Jacquelyn Martin)

Il Segretario per la salute e i servizi umani Robert F. Kennedy Jr. parla mentre il Segretario per l'istruzione Linda McMahon ascolta durante un evento della Commissione Make America Healthy Again nella Sala Est della Casa Bianca giovedì 22 maggio 2025 a Washington. (AP Photo/Jacquelyn Martin)Gli autori del rapporto Make America Healthy Again pubblicato dal segretario alla Salute e ai Servizi Umani Robert F. Kennedy Jr. lo hanno pubblicizzato come una valutazione fondamentale che fornisce una base scientifica comune per modellare la politica sanitaria.

Ma quella base scientifica sembrava contenere errori generati da un probabile colpevole: l’intelligenza artificiale generativa.

Almeno sette delle citazioni del rapporto erano problematiche come NOTUS segnalato per primo . Quattro contenevano titoli di articoli che non esistono e tre descrivevano erroneamente i risultati degli articoli.

Alla domanda sul rapporto, la portavoce della Casa Bianca Karoline Leavitt attribuito gli errori a problemi di formattazione che non vanificano la sostanza del rapporto. Quando è stato chiesto se l’intelligenza artificiale fosse stata utilizzata nella produzione del rapporto, Leavitt ha rinviato al Dipartimento di salute e servizi umani.

Da allora il rapporto MAHA è stato aggiornato online. (Ecco il versione archiviata .) PolitiFact ha contattato il Dipartimento della salute e dei servizi umani ma non ha ricevuto risposta.

I modelli di intelligenza artificiale sono addestrati a imitare il linguaggio utilizzato dagli esseri umani prevedendo una parola dopo l’altra in una sequenza. Sebbene i chatbot basati sull’intelligenza artificiale come ChatGPT spesso riescano a produrre testo che sembra scritto da un essere umano, spesso non riescono a garantire che ciò che dicono sia reale.

Le false citazioni erano formattate correttamente e includevano identificatori di oggetti digitali o DOI dal suono realistico.

Ma il fatto che non esistessero più articoli citati è un segno distintivo delle citazioni generate dall’intelligenza artificiale che spesso replicano la struttura dei riferimenti accademici senza collegarsi a fonti reali, ha affermato Oren Etzioni, professore emerito dell’Università di Washington e ricercatore sull’intelligenza artificiale.

PolitiFact ha parlato con ricercatori di intelligenza artificiale e neuroscienze dei campanelli d’allarme relativi all’intelligenza artificiale del rapporto.

Gli errori mostrano i segni distintivi delle allucinazioni dell'IA

I ricercatori hanno affermato che la presenza di articoli fabbricati è probabilmente il risultato di allucinazioni dell’intelligenza artificiale o di risultati che possono sembrare plausibili ma non reali.

L’intelligenza artificiale sta avanzando rapidamente ma è ancora soggetta ad allucinazioni. Quando viene richiesto di generare riferimenti accademici, i modelli di intelligenza artificiale generativa spesso inventano qualcosa se non trovano corrispondenze esatte, soprattutto se viene richiesto di supportare un punto specifico, ha affermato Etzioni.

Steven Piantadosi, professore di psicologia e neuroscienze presso l'Università della California a Berkeley, che dirige il laboratorio di calcolo e linguaggio, ha affermato che i modelli di intelligenza artificiale non hanno alcun modo di sapere cosa è vero o cosa conta come prova.

Tutto quello che fanno è abbinare il modello statistico nel testo, ha detto. È interessante e importante che riescano a farlo molto bene, ma le dipendenze statistiche tra i personaggi non sono ciò su cui dovresti costruire una politica pubblica.

Il Washington Post segnalato che alcune citazioni includevano oaicite nei loro URL which Utenti ChatGPT hanno riportato come testo che appare nel loro output. (OpenAI possiede ChatGPT.)

Risultati sull’uso di droghe per la salute mentale degli adolescenti e altri collegati a citazioni false

Anche nelle citazioni legittime del rapporto alcuni risultati sono stati travisati o esagerati, un altro errore comune agli strumenti di intelligenza artificiale generativa che possono produrre con sicurezza riassunti errati della ricerca, ha affermato Etzioni.

La versione aggiornata del rapporto MAHA ha sostituito le citazioni false con fonti che ne sostenevano i risultati e in alcuni punti ha rivisto il modo in cui presentava i risultati precedentemente collegati alle citazioni false. (Vedi il nostro foglio di calcolo .)

Uno degli articoli falsi segnalati da NOTUS era intitolato Cambiamenti nella salute mentale e nell’uso di sostanze tra gli adolescenti statunitensi durante la pandemia di COVID-19. La riga che lo citava diceva che circa il 20-25% degli adolescenti riferiva sintomi di ansia e il 15-20% riferiva sintomi depressivi con le ragazze che mostravano tassi significativamente più alti.

Un esame più attento della citazione mostra perché non è autentica: la ricerca del titolo non produce un articolo reale cliccando su DUE collegamenti nella citazione porta a una pagina di errore che dice DOI non trovato e guardando il volume JAMA Pediatrics e il numero di emissione a cui si fa riferimento porta a un articolo con titolo diverso e autori diversi.

Il rapporto MAHA aggiornato ha sostituito la citazione con a Rapporto 2024 da KFF che ha affermato che nel 2021 e 2022 il 21% degli adolescenti ha riportato sintomi di ansia e il 17% ha riportato sintomi di depressione.

Il rapporto originale citava due articoli inesistenti in una sezione sulla pubblicità diretta al consumatore per l'uso di farmaci per l'ADHD da parte dei bambini e l'uso di antidepressivi da parte degli adolescenti. Il rapporto afferma che la pubblicità degli antidepressivi negli adolescenti mostra vaghi elenchi di sintomi che si sovrappongono ai comportamenti tipici degli adolescenti ed è collegata a richieste inappropriate di antidepressivi da parte dei genitori.

La nuova versione del rapporto ora recita che la pubblicità DTC si ritiene incoraggi un maggiore uso di farmaci psicotropi negli adolescenti, compresi i corsi di antipsicotici e antidepressivi ansiolitici, che ora citano un studio del 2006 che utilizzava dati dal 1994 al 2001. Gli autori credevano che la pubblicità diretta al consumatore avesse avuto un ruolo nell'incoraggiare un maggiore uso di psicotropi.

Un altro risultato nel rapporto MAHA sulle prescrizioni di farmaci per l'asma afferma che circa il 25-40% dei casi lievi ricevono prescrizioni eccessive, citando un articolo inesistente. Lo pneumologo pediatrico Dr. Harold J. Farber, indicato come il presunto primo autore dell’articolo, ha detto a NOTUS che si trattava di una generalizzazione eccessiva della sua ricerca.

Il rapporto aggiornato ha rimosso tali cifre. Ora si legge che esistono prove di una prescrizione eccessiva di corticosteroidi orali per i casi lievi di asma.

film e programmi tv di linda hamilton

L’incidente del rapporto MAHA evidenzia i rischi derivanti dall’inclusione di contenuti generati dall’intelligenza artificiale nei rapporti ufficiali del governo senza revisione umana.

Se gli strumenti di intelligenza artificiale fossero utilizzati per generare citazioni per un rapporto federale che solleva seri dubbi di responsabilità. Senza una chiara divulgazione o processi di verifica non c'è modo per i lettori di sapere se le informazioni sono fondate su prove reali, ha affermato Etzioni. Nelle questioni di salute pubblica, che coinvolgono soprattutto i bambini e la salute mentale, questi errori sono particolarmente preoccupanti.

Questo controllo dei fatti era originariamente pubblicato da PolitiFact che fa parte del Poynter Institute. Vedi le fonti per questo fact check Qui .